代码和多模式搜索达到了顶级SOTA! Zhiyuan BGE矢量

栏目:行业动态 发布时间:2025-05-23 10:21

收购的采集技术在代码和多模式方案中起着重要作用,而向量模型是收购系统不可或缺的一部分。为了这...

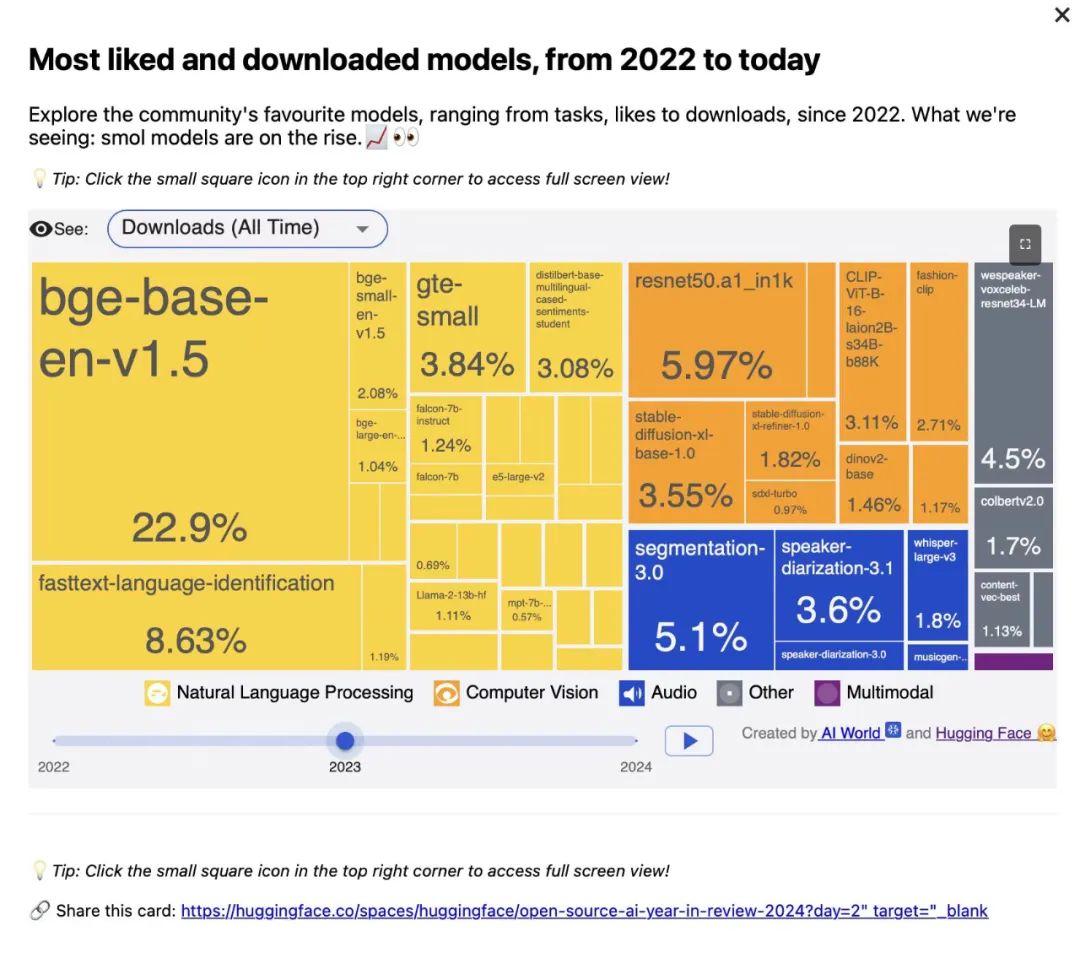

收购的采集技术在代码和多模式方案中起着重要作用,而向量模型是收购系统不可或缺的一部分。为了应对这一要求,Zhiyuan研究所最近开发了三个矢量模型,其中包括代码向量模型BGE-CODE-V1,多模式矢量BGE-VL-V1.5和Visual Vector Model Model Model Model Model BGE-VL-Screenshot Vector模型。这些模型在代码和多模式采集中取得了最佳结果,并在Coir Fields,Code-Rag,MMEB,MVRB等中达到了主要测试基准的顶部。自2023年8月发行以来,BGE已成为中国的首个AI模型,该模型在2023年在所有发布的车型中列出了所有发布的模型。目前,三种BGE-Code-V1型号,BGE-VL-V1.5,BGE-VL-Screenshot为社区提供了支持,以支持相关性和工业的研究。 BGE-CODE-V1:模型地址:https://huggingface.co/baai/bge-tode-v1 Project Homepage: https://github.com/flagopen/flalamedding/tree/master/research/bge_coder paper link: https://arxiv.org/abs/2505.12697bge-vl-v1.5: Model Address: https://huggingface.co/baai/bge-vl-v1.5-zs项目homepage:https://github.com/flagopen/flagopen/flalameddin g/tree/tree/tree/master/master/beys/bge_vl链接: https://huggingface.co/baai/bge-vl-creenshot项目主页:https://github.com/flagopen/flagopen/flalamedding/tree/tree/master/master/master/research/bge_vl_screenshot论文矢量表示和语义搜索解决方案的不同类型的数据。它推出了许多涵盖中文和英语模型,许多搜索和维修模型的版本,并继续刷新MTEB,C-MTEB,Beir和Miracl。就像文本矢量评论的基本基准一样。 BGE吸引了很多关注该行业由于高性能和开放资源性能。它被广泛用于破布,神经搜索和其他情况。总共下载超过6亿次,其中包括许多AI国内外公司。当前,采集技术正在逐渐从传统的文本方案扩展到涵盖多模式数据(例如代码和愿景)的应用程序。但是,与文本字段相比,找到现有的向量模型对代码和视觉模式的影响仍然需要改进。 Zhiyuan Research Institute发布的三种新模型为建造更强的多模式增强系统提供了强有力的支持。 BGE-Code-V1一代的新一代。通过快速开发基本的模型代码功能,具有辅助编程(例如光标和副驾驶)的工具极大地提高了其生产力。当面对一百万级代码库时,要突出显示获得代码块的需求,因此A了解模型的删除代码的能力很重要。 BGE-CODE-V1是新一代的代码向量模型,以QWEN2.5-CODER-1.5B作为基础开发。它专为与获得代码有关的各种任务而设计,并配备了对多语言文本的深刻理解。 ANG Modelo是根据COIR训练集和大量高质量合成代码文本数据进行培训的,并使用课程研究来进一步提高使用BGE-GEMMA2-Multingual数据提取和STS来进一步提高对代码和文本功能的理解。 BGE-CODE-V1适用于各种实际应用情况,例如开发文档搜索,代码基础语义检索,获取跨语言信息以及其他实际应用情况。这是代码介绍任务的最佳选择。 Coir Code Benchmarks在4个类别中收集8个子任务,涵盖14种编程语言,可以有效地评估VA中模型采集的能力巧妙的混合自然语言和代码情况。 Coderag基础基准测试了代码搜索模型搜索增强(RACG)的性能。 BGE-CODE-V1超过了Google,Voyage AI,Salesforce,Jina和其他商业/开放资源模型,这些模型对这两个基准都有很大的好处,并获得了最高的SOTA。 BGE-VL-V1.5一般多模式搜索模型BGE-VL-V1.5完成了BGE-VL-VL-V1.5多模式搜索任务是基于LLAVA-1.6(7.57B参数)的一般多模式搜索模型的新一代。升级图形和文本理解功能并具有更强的获取能力是全面的。 BGE-VL-V1.5根据图形和文本对齐数据收集了100万个自然数据和合成数据(涵盖图像标题数据,视觉问询和回答数据以及分类工作数据),以多任务练习的图形和文本对齐数据收集活动。根据MeGapairs数据,BGE-VL-V1.5对多模式采集活动具有显着的性能优势。它不仅在图像中表现出色,而且在一般多模式方案中表现出很高的灵活性和准确性。它适用于图片和文本匹配,多模式问答以及跨模式建议等场景。左侧是MMEB上BGE-VL-V1.5-Z的性能和其他零摄像机模型,而右边是BGE-VL-V1.5-MMEB的性能,在获得MMEB基准的工作中。 MMEB是使用最广泛的多模式矢量基准,由四种类型的任务组成:分类,视觉问题和答案,获取和视觉基础知识。基于零射击设置(未使用MMEB训练集),BGE-VL-V1.5-ZS在MMEB基准测试上刷新了零摄模的最优质性能;在搜索任务中,MMEB微调BGE-VL-V1.5-MMEB以72.16分的速度领先SOTA。实用和强大的模型视觉视觉视觉视觉效果。在实际情况下,诸如网页和文档之类的多模式活动通常由多元素混合数据(例如图形,符号和图表)组成。这种类型的工作称为“视觉信息检索”(Vis-ir)。因此,多模型模型不仅需要能够从复杂的结构中视觉上提取基本信息,而且还需要准确理解文本和视觉语义。当前,现有的搜索模型在此类活动中表现不佳。基于屏幕截图和文本搜索的BGE-VL-SC BGE-VL-ScreenShot模型是BQWEN2.5-VL-3B-3B肝脏肝,并接受了七种类型的数据资源的培训,例如新闻,产品,纸张,文档和项目主页,并收集了超过1300万张屏幕截图和700万集筛选的筛选示例,并收集了700万套筛选的筛选。为了准确评估模型在Vis-Ir工作中的性能,该团队设计并启动了多模式检索基准MVRB(大量VISIR -IR基准测试,链接列表:https://huggingface.co/spaces/baai/mvrb_aderboard),涵盖了4个活动,其中包括ScreenShot搜索,Compents ScreiteShot Searach,ScreenShot searach,ScreenShot QA和OpenHot搜索,Composite Screites Sexenshot搜索,ScreenShot搜索,ScreenShot分类,ScreenShot分类,总计20个设置的数据。左侧是MVRB多语言审查的结果,与BGE-VL-Screenshot相比,MVRB对MVRB多种模式搜索模型的各种尺寸的结果的结果是,在4个活动中表现良好,SOTA在4个活动中的表现良好,全面得分为60.61。在此基础上,通过少量的Query2Screenshot多语言数据培训,该模型在英语的多语言活动中取得了出色的表现。 Zhiyuan研究所将继续加深其对向量模型和搜索增强技术的种植,并进一步增强BGE模型系列的能力和能力。将来,我们期待与更科学的机构合作S和行业合作伙伴共同努力促进获取和人工智能的发展。欢迎研究人员和开发人员注意并使用一系列BGE模型聚集在一起,以开发开放而繁荣的生态系统资源。

收购的采集技术在代码和多模式方案中起着重要作用,而向量模型是收购系统不可或缺的一部分。为了应对这一要求,Zhiyuan研究所最近开发了三个矢量模型,其中包括代码向量模型BGE-CODE-V1,多模式矢量BGE-VL-V1.5和Visual Vector Model Model Model Model Model BGE-VL-Screenshot Vector模型。这些模型在代码和多模式采集中取得了最佳结果,并在Coir Fields,Code-Rag,MMEB,MVRB等中达到了主要测试基准的顶部。自2023年8月发行以来,BGE已成为中国的首个AI模型,该模型在2023年在所有发布的车型中列出了所有发布的模型。目前,三种BGE-Code-V1型号,BGE-VL-V1.5,BGE-VL-Screenshot为社区提供了支持,以支持相关性和工业的研究。 BGE-CODE-V1:模型地址:https://huggingface.co/baai/bge-tode-v1 Project Homepage: https://github.com/flagopen/flalamedding/tree/master/research/bge_coder paper link: https://arxiv.org/abs/2505.12697bge-vl-v1.5: Model Address: https://huggingface.co/baai/bge-vl-v1.5-zs项目homepage:https://github.com/flagopen/flagopen/flalameddin g/tree/tree/tree/master/master/beys/bge_vl链接: https://huggingface.co/baai/bge-vl-creenshot项目主页:https://github.com/flagopen/flagopen/flalamedding/tree/tree/master/master/master/research/bge_vl_screenshot论文矢量表示和语义搜索解决方案的不同类型的数据。它推出了许多涵盖中文和英语模型,许多搜索和维修模型的版本,并继续刷新MTEB,C-MTEB,Beir和Miracl。就像文本矢量评论的基本基准一样。 BGE吸引了很多关注该行业由于高性能和开放资源性能。它被广泛用于破布,神经搜索和其他情况。总共下载超过6亿次,其中包括许多AI国内外公司。当前,采集技术正在逐渐从传统的文本方案扩展到涵盖多模式数据(例如代码和愿景)的应用程序。但是,与文本字段相比,找到现有的向量模型对代码和视觉模式的影响仍然需要改进。 Zhiyuan Research Institute发布的三种新模型为建造更强的多模式增强系统提供了强有力的支持。 BGE-Code-V1一代的新一代。通过快速开发基本的模型代码功能,具有辅助编程(例如光标和副驾驶)的工具极大地提高了其生产力。当面对一百万级代码库时,要突出显示获得代码块的需求,因此A了解模型的删除代码的能力很重要。 BGE-CODE-V1是新一代的代码向量模型,以QWEN2.5-CODER-1.5B作为基础开发。它专为与获得代码有关的各种任务而设计,并配备了对多语言文本的深刻理解。 ANG Modelo是根据COIR训练集和大量高质量合成代码文本数据进行培训的,并使用课程研究来进一步提高使用BGE-GEMMA2-Multingual数据提取和STS来进一步提高对代码和文本功能的理解。 BGE-CODE-V1适用于各种实际应用情况,例如开发文档搜索,代码基础语义检索,获取跨语言信息以及其他实际应用情况。这是代码介绍任务的最佳选择。 Coir Code Benchmarks在4个类别中收集8个子任务,涵盖14种编程语言,可以有效地评估VA中模型采集的能力巧妙的混合自然语言和代码情况。 Coderag基础基准测试了代码搜索模型搜索增强(RACG)的性能。 BGE-CODE-V1超过了Google,Voyage AI,Salesforce,Jina和其他商业/开放资源模型,这些模型对这两个基准都有很大的好处,并获得了最高的SOTA。 BGE-VL-V1.5一般多模式搜索模型BGE-VL-V1.5完成了BGE-VL-VL-V1.5多模式搜索任务是基于LLAVA-1.6(7.57B参数)的一般多模式搜索模型的新一代。升级图形和文本理解功能并具有更强的获取能力是全面的。 BGE-VL-V1.5根据图形和文本对齐数据收集了100万个自然数据和合成数据(涵盖图像标题数据,视觉问询和回答数据以及分类工作数据),以多任务练习的图形和文本对齐数据收集活动。根据MeGapairs数据,BGE-VL-V1.5对多模式采集活动具有显着的性能优势。它不仅在图像中表现出色,而且在一般多模式方案中表现出很高的灵活性和准确性。它适用于图片和文本匹配,多模式问答以及跨模式建议等场景。左侧是MMEB上BGE-VL-V1.5-Z的性能和其他零摄像机模型,而右边是BGE-VL-V1.5-MMEB的性能,在获得MMEB基准的工作中。 MMEB是使用最广泛的多模式矢量基准,由四种类型的任务组成:分类,视觉问题和答案,获取和视觉基础知识。基于零射击设置(未使用MMEB训练集),BGE-VL-V1.5-ZS在MMEB基准测试上刷新了零摄模的最优质性能;在搜索任务中,MMEB微调BGE-VL-V1.5-MMEB以72.16分的速度领先SOTA。实用和强大的模型视觉视觉视觉视觉效果。在实际情况下,诸如网页和文档之类的多模式活动通常由多元素混合数据(例如图形,符号和图表)组成。这种类型的工作称为“视觉信息检索”(Vis-ir)。因此,多模型模型不仅需要能够从复杂的结构中视觉上提取基本信息,而且还需要准确理解文本和视觉语义。当前,现有的搜索模型在此类活动中表现不佳。基于屏幕截图和文本搜索的BGE-VL-SC BGE-VL-ScreenShot模型是BQWEN2.5-VL-3B-3B肝脏肝,并接受了七种类型的数据资源的培训,例如新闻,产品,纸张,文档和项目主页,并收集了超过1300万张屏幕截图和700万集筛选的筛选示例,并收集了700万套筛选的筛选。为了准确评估模型在Vis-Ir工作中的性能,该团队设计并启动了多模式检索基准MVRB(大量VISIR -IR基准测试,链接列表:https://huggingface.co/spaces/baai/mvrb_aderboard),涵盖了4个活动,其中包括ScreenShot搜索,Compents ScreiteShot Searach,ScreenShot searach,ScreenShot QA和OpenHot搜索,Composite Screites Sexenshot搜索,ScreenShot搜索,ScreenShot分类,ScreenShot分类,总计20个设置的数据。左侧是MVRB多语言审查的结果,与BGE-VL-Screenshot相比,MVRB对MVRB多种模式搜索模型的各种尺寸的结果的结果是,在4个活动中表现良好,SOTA在4个活动中的表现良好,全面得分为60.61。在此基础上,通过少量的Query2Screenshot多语言数据培训,该模型在英语的多语言活动中取得了出色的表现。 Zhiyuan研究所将继续加深其对向量模型和搜索增强技术的种植,并进一步增强BGE模型系列的能力和能力。将来,我们期待与更科学的机构合作S和行业合作伙伴共同努力促进获取和人工智能的发展。欢迎研究人员和开发人员注意并使用一系列BGE模型聚集在一起,以开发开放而繁荣的生态系统资源。